Introduction

L’IA générative est incontestablement l’une des l’avancées technologiques les plus prometteuses de ces dernières années. Avec son lot d’applications multiples qui faciliteront les usages des utilisateurs, elle représentera un levier de productivité pour les entreprises.

Contrairement à l’IA dite « classique » qui permet principalement d’analyser des données et de réaliser des calculs prédictifs, l’IA générative est capable de créer des contenus de toute sorte (textes, images, vidéos) sur la base d’une quantité importante de données.

L’IA générative devient ainsi en enjeu de différentiation concurrentielle notamment pour les fournisseurs de services Cloud qui souhaitent profiter de ce levier technologique pour booster leurs offres et gagner de nouvelles parts de marché.

Parmi les leaders, Microsoft a su développer assez rapidement sa solution d’IA générative Microsoft Copilot basée sur le modèle pionner OpenAI et l’a intégrée à son écosystème Digital Workplace Microsoft 365 au travers de plusieurs composantes :

- Microsoft 365 Copilot : services Microsoft Graph + Microsoft 365 Apps (Word, Excel, PowerPoint, Outlook, Teams)

- Power Platform Copilot et Power BI Copilot : services Power Apps + Power Automate + Power BI

- Copilot pour Windows : système d’exploitation Windows 11 + moteur de recherche Bing + navigateur Web EDGE

- Microsoft Security Copilot : services de sécurité Microsoft Defender for Endpoint et Microsoft Defender for Office 365.

Cette offre étant disponible depuis fin 2023, les entreprises s’interrogent désormais sur la manière d’intégrer au mieux Microsoft Copilot au sein de leur organisation.

En tant que cabinet de conseil en cybersécurité, Lovell Consulting souhaite apporter des éléments de réponse et proposer sa vision. De notre point de vue, l’activation de Microsoft Copilot doit se faire à l’image des autres services Microsoft 365 : en menant au préalable une analyse des risques induits.

C’est à ce titre que nous publions une première partie de cet article qui porte sur les risques liés à l’utilisation de Microsoft Copilot. Puis ensuite nous publierons une seconde partie qui reprendra les réponses apportées par Microsoft et évaluera la nécessité d’en intégrer davantage.

Risques

L’un des atouts de Microsoft Copilot est de pouvoir agréger massivement les données disponibles depuis l’écosystème Microsoft 365, lui permettant ainsi de s’imprégner du contexte de l’entreprise et d’apporter des réponses adaptées aux utilisateurs.

Dès lors, la donnée devient le principal enjeu à prendre en considération lorsque l’on souhaite déployer cette solution d’IA générative.

Surexposition des données

Le recul sur l’utilisation des solutions collaboratives nous montre que pour des raisons de facilité, les documents sont souvent partagés plus largement que nécessaire en termes d’auditoire et de permissions. Or en agrégant de l’information issue de documents parfois sensibles, Microsoft Copilot peut mettre en exergue ces données et contribuer ainsi au risque de divulgation de données sensibles à des utilisateurs qui n’avaient jusque-là pas connaissance de leur existence.

Cela est notamment le cas lorsque les données ne sont ni classifiées ni protégées au travers d’une solution de chiffrement comme Azure Information Protection, ou lorsque la gestion des droits d’accès aux espaces de stockage est anarchique et décentralisée.

Négligence des utilisateurs

Avec toutes les annonces prometteuses autour de Microsoft Copilot, les utilisateurs peuvent à tort prendre pour argent comptant les réponses apportées par la solution d’IA générative. Or en s’appuyant sur des documents obsolètes voir même erronés, Microsoft Copilot peut absorber des informations inappropriées pour ensuite les diffuser et contribuer ainsi au risque de propagation de fausses informations à des utilisateurs qui ne vont pas challenger les résultats.

Cela est d’autant plus problématique lorsque des tiers malintentionnés vont délibérément corrompre un ensemble de données pour orienter l’IA dans un sens inapproprié. C’est ce qu’on appelle le data poisoning attack.

Détournement des usages

Microsoft Copilot propose des résultats si pertinents et variés qu’il devient parfois difficile d’identifier l’auteur entre l’IA et un individu. Or en l’absence de garde-fous et par manque de vigilance des utilisateurs, des tiers malveillants peuvent exploiter la solution d’IA générative à des fins cybercriminelles en vue de perfectionner leurs techniques de social engineering et de phishing qui sont déjà les premiers vecteurs d’attaque de la Digital Workplace.

Une autre tendance consiste également à corrompre Microsoft Copilot avec des requêtes ciblées dans le but d’exploiter une faiblesse de l’agent et le forcer à générer des résultats pouvant entraîner la divulgation d’informations sensibles ou l’exécution de codes malicieux.

Propriété intellectuelle

Étant donné sa conception, Microsoft Copilot se base sur des données existantes pour créer de nouveaux contenus sans intervention humaine. Dès lors se pose la question du droit d’exploitation d’un contenu créé par une IA à l’insu du propriétaire des données d’origine. Si la législation encadre le droit d’auteur entre les individus, elle n’apporte pas encore une réponse équivalente lorsqu’une IA entre dans l’équation, exposant ainsi les entreprises qui utilisent Microsoft Copilot à des risques juridiques.

Conclusion

Ainsi, nous venons de voir qu’avant d’être à l’origine de nouveaux risques, Microsoft Copilot met avant tout en exergue des risques déjà existants.

Il convient alors de se demander si face à cela, Microsoft apporte des éléments de réponse permettant de réduire la portée de ces risques. C’est dans cette optique que nous publierons une seconde partie pour évaluer les mesures apportées par Microsoft et juger de la nécessité d’en intégrer davantage.

Deuxième partie

Démarche d’intégration de Microsoft Copilot

Dans une précédente partie, nous avons exposé les risques induits par le déploiement de la solution d’IA générative Microsoft Copilot au sein d’une organisation.

Dans cette seconde partie, nous allons commencer par passer en revue les mesures de sécurité mises en place par Microsoft afin d’atténuer ces risques. En tant que cabinet de conseil en cybersécurité, nous vous présenterons ensuite et en complément une démarche globale d’intégration sécurisée de cette solution d’IA générative.

Mesures de sécurité de Microsoft

Surexposition des données

Microsoft Copilot hérite des politiques de sécurité, conformité et confidentialité définies dans Microsoft 365, parmi lesquelles le modèle d’autorisation et d’habilitation en œuvre. Cela permet ainsi de conserver les permissions déjà en place sur les services comme SharePoint Online, Teams et OneDrive, et donc de restreindre la portée de Microsoft Copilot aux seules données déjà accessibles par les utilisateurs.

Par ailleurs, contrairement aux autres solutions d’IA générative basées sur le modèle OpenAI, les interactions entre les utilisateurs et la solution de Microsoft (prompt en anglais) ne sont pas utilisées pour améliorer le modèle. Les données exploitées par Microsoft Copilot sont donc conservées au sein de l’organisation. Cela permet également de se prémunir de l’exploitation de toute faiblesse de la solution en vue de faire transiter des informations sensibles entre les organisations.

Négligence des utilisateurs

Pour sensibiliser les utilisateurs à examiner la pertinence et l’exactitude des réponses apportées par sa solution d’IA générative, Microsoft cite explicitement dans les requêtes la provenance des informations (sources) et invite les utilisateurs via un bouton dédié à examiner et ajuster le contenu en fonction de leur expertise et du contexte.

Propriété intellectuelle

En ce qui concerne la propriété intellectuelle, Microsoft apporte un premier élément de réponse avec le déploiement de garde-fous qui filtrent les données susceptibles d’enfreindre les droits d’auteur, et s’engage au travers du Copilot Copyright Commitment à indemniser les clients poursuivis pour violation des droits d’auteur dans le cadre des résultats générés par l’IA générative.

Démarche d’intégration pour les entreprises

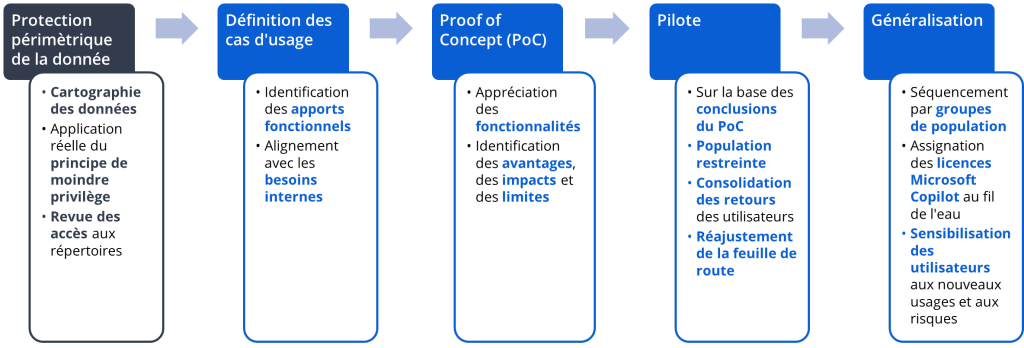

Prérequis : protection périmétrique de la donnée

Nous pensons que l’intégration de la solution d’IA générative passe d’abord par l’adoption d’une posture de sécurité centrée sur le principal enjeu de l’IA générative : la donnée.

Cette stratégie implique, dans un premier temps, la réalisation d’une cartographie des données en circulation dans Microsoft 365. Cela permet à une entreprise de mieux connaître les données traitées par les utilisateurs, leur emplacement et ainsi leur niveau d’exposition. Sur cette base, il est possible :

- D’établir une politique de classification et de protection des données adaptée au contexte de l’entreprise ;

- De protéger les données sensibles avec par exemple une solution de chiffrement comme Azure Information Protection.

La deuxième étape est l’application réelle du principe de moindre privilège au plus près des données. Les utilisateurs ne doivent disposer que des accès et permissions qui leurs sont réellement nécessaires dans le cadre de leurs activités et ce pour une durée définie. Cette lutte contre le partage excessif permet de s’assurer que Microsoft Copilot ne s’appuie pas sur des informations sensibles ne les divulgue pas non plus à des utilisateurs qui n’avaient jusque-là pas connaissance de leur existence.

La troisième étape consiste à réaliser une revue des accès aux répertoires. Cette activité doit être encadrée et pilotée par la DSI au sein de campagnes de re-certification et réalisée sous la responsabilité des propriétaires des répertoires. Cela peut se faire au travers d’outils existant déjà sur le marché, et notamment du côté de Microsoft. En effet, avec le partage excessif (cité précédemment) et la rotation des effectifs au sein d’un projet ou d’une équipe, il arrive souvent que les utilisateurs bénéficient encore des accès correspondant à leurs activités précédentes. Avec ces revues, il est possible de vérifier que seules les personnes toujours habilitées sur l’instant T bénéficient des accès en question, permettant ainsi de réduire une fois de plus la portée de Microsoft Copilot.

Processus d’intégration spécifique à Microsoft Copilot

Une fois le prérequis couvert, nous pensons que l’intégration de Microsoft Copilot doit suivre une démarche orientée cas d’usage. En effet, cette étape vise à déterminer les apports fonctionnels de la solution et les aligner avec les besoins des équipes internes. Il s’agit en général de la recherche d’un gain de productivité, d’efficacité et de performance.

Ces fonctionnalités doivent ensuite être éprouvées au travers d’un Proof of concept (PoC) afin d’identifier les avantages de la solution, mais aussi ses impacts et limites.

Sur la base des conclusions du PoC (ici positifs), le déploiement de Microsoft Copilot devra ensuite être initialisé avec le déploiement d’un pilote sur une population restreinte et en adéquation avec les cas d’usages identifiés précédemment. Il peut s’agir entre autres des équipes dirigeantes, commerciales, marketing, IT, financières, etc.

Ce pilote sera l’occasion de consolider les retours des utilisateurs pour réajuster la feuille de route en vue d’une généralisation de la solution, qui pourra être séquencée par groupes de population (via l’assignation des licences Microsoft Copilot au fil de l’eau).

En transversalité de toutes ces étapes, il est important de sensibiliser les utilisateurs aux nouveaux usages, bonnes pratiques et surtout aux risques induits par l’utilisation de ce nouvel outil. Notamment la protection des données sensibles, la nécessité de challenger les contenus proposés par Microsoft Copilot et s’assurer de leur pertinence selon le contexte avant de les exploiter et diffuser.

Ouverture

Par le biais de l’intégration en preview d’un AI Hub dans la console de gouvernance des données Microsoft Purview, Microsoft souhaite apporter des outils de suivi et de contrôle de l’utilisation de Microsoft Copilot au sein d’une organisation. Les entreprises devront s’emparer de ces nouvelles fonctionnalités de manière à suivre les usages en vue d’adapter les stratégies de protection des données sensibles.

Conclusion

L’utilisation de Microsoft Copilot n’est pas sans risques. Néanmoins, avec une posture de sécurité orientée sur la donnée engagée en amont de toute démarche d’intégration, et un bon accompagnement des utilisateurs aux nouveaux usages, le cabinet de conseil Lovell Consulting estime que les entreprises peuvent et devraient bénéficier de ce nouveau levier technologique. C’est à ce titre que nous proposons un accompagnement sur-mesure, adapté au contexte des entreprises et qui s’appuie sur notre expérience et les convictions que nous avons développé sur ces sujets à forts enjeux Métier et cyber.